¿Dónde dejé las llaves?

Cuando buscamos un objeto, nuestros ojos efectúan saltitos casi imperceptibles a partir de la información que va recopilando el cerebro. Esos movimientos mínimos de la mirada intentan predecirse mediante algoritmos, que las neurociencias aprovechan para tratar de interpretar los procesos neuronales subyacentes. En un experimento con voluntarios, un equipo de investigación de Exactas UBA logró un avance en ese sentido.

Encontrar el abrelatas en el cajón de la cocina, localizar el celular o las llaves perdidas, buscar una palabra en un texto o una cara en una fotografía. Nuestros ojos exploran lugares distintos un montón de veces al día.

En general, encontrar rápido un objeto -o descartar lo antes posible su presencia en donde lo estamos buscando- suele tener que ver con la ansiedad de esta época por no perder el tiempo. Pero, para los primeros humanos, hallar de inmediato una piedra o un palo en el suelo podía significar la diferencia entre mantenerse vivo y conocer la muerte. Por eso nuestro cerebro, que es el mismo que el de nuestros ancestros, trata de reducir al mínimo el tiempo que nos toma la búsqueda visual de un objeto.

Décadas de investigaciones demuestran que la habilidad para encontrar algo depende de nuestra capacidad para recopilar información visual mediante una secuencia de movimientos oculares. Es decir, la búsqueda visual no es azarosa. Primero, fijamos la mirada en un punto que está relacionado con nuestros conocimientos previos. Por ejemplo, si estamos buscando un lápiz enfocaremos los ojos en algún lugar donde podría ser factible hallar ese objeto, como un escritorio. Después, nuestra mirada se desplazará rápidamente a otro punto del escritorio, después a otro y así sucesivamente hasta que encontremos lo que estábamos buscando o, si no, hasta que decidamos que eso que necesitábamos no está ahí.

Para los primeros humanos, hallar de inmediato una piedra o un palo podía significar la diferencia entre mantenerse vivo y conocer la muerte.

Sin que nos demos cuenta, durante ese recorrido visual nuestros ojos se aproximan al objetivo dando saltitos que duran milisegundos. Un tiempo infinitamente pequeño. Pero suficiente para tomar información de la escena y mandársela al cerebro, que la procesa y la devuelve tratando de llevarnos rápidamente al objetivo. Cada “foto” que toman nuestros ojos le sirve al cerebro para ir dirigiendo la mirada y, de esta manera, minimizar el número de movimientos oculares necesarios para encontrar lo que estamos buscando.

Modelo de dos mundos

Hay modelos computacionales que intentan imitar lo que hace el ojo. La inteligencia artificial utiliza esa información para desarrollar algoritmos que sirvan, por ejemplo, para que una máquina pueda detectar objetos. En general, esos programas de computación se enfocan en los primeros pasos de la búsqueda visual con el objetivo de predecir, por ejemplo, qué tan rápido se puede encontrar un objetivo. Además, suelen trabajar con imágenes artificiales, es decir, dibujos, como esos que nos desafían a encontrar un triángulo particular entre un conjunto de triángulos muy similares en un lapso determinado.

“Nosotros nos centramos en tratar de lograr un algoritmo que pudiera predecir eficazmente el proceso de búsqueda completo y, además, lo hicimos sobre imágenes naturales”, comenta Guillermo Solovey, investigador del CONICET en el Instituto de Cálculo (IC) de la Facultad de Ciencias Exactas y Naturales de la UBA (Exactas UBA).

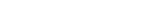

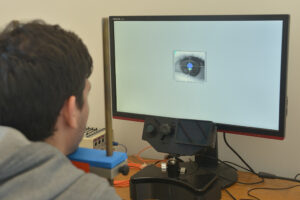

Para alcanzar ese propósito, hicieron un experimento con decenas de voluntarios. Los hacían buscar un objeto determinado en una fotografía proyectada en una pantalla y, mientras, seguían el recorrido de los ojos con una cámara que registraba, a una velocidad de dos mil cuadros por segundo, hacia dónde miraban.

Una parte de los desarrollos de la inteligencia artificial está dirigida a crear algoritmos que puedan detectar objetos y reconocerlos.

“Teníamos registrados con mucha definición todos los puntos que habían recorrido con la mirada. Esa información la usamos como insumo para poner a prueba distintos algoritmos que desarrollamos tratando de imitar el movimiento de la mirada dentro de la imagen”, cuenta Gastón Bujía, becario doctoral del CONICET en el IC y en el Laboratorio de Inteligencia Artificial Aplicada de Exactas UBA.

Para construir esos algoritmos, utilizaron algunos elementos de los modelos computacionales de la inteligencia artificial y los combinaron de manera original con un modelo clásico, de inferencia bayesiana (así se llama), que trabaja en base a probabilidades y que suele ser utilizado por las neurociencias para sus experimentos.

“Nosotros utilizamos lo mejor de los dos mundos”, dice Bujía y explica: “Los modelos computacionales de la inteligencia artificial son muy sofisticados y andan muy bien para captar ‘la esencia’ de la imagen y hacer un montón de tareas. Pero a la hora de interpretar por qué un individuo eligió mirar hacia un lado o hacia el otro nos dejan sin herramientas. Nuestro modelo incorpora el modelo bayesiano, que permite ir viendo cómo se toman las decisiones. Eso nos permitió desarrollar un algoritmo que propone un mecanismo claro e interpretable de la manera en que buscamos objetos”.

Para alcanzar su propósito, los investigadores idearon un experimento con decenas de voluntarios. Foto: Diana Martinez LLaser. Exactas UBA.

El algoritmo logrado por el grupo de investigación de Exactas UBA es menos sofisticado en su complejidad que los de la inteligencia artificial. No obstante, “es un modelo que, en su eficacia, está a la par de los modelos más sofisticados de la inteligencia artificial y, también, tiene la ventaja de predecir todo el comportamiento completo”, señala Bujía, y subraya: “Además, nuestro modelo puede trabajar con imágenes naturales”.

Por su parte, Solovey agrega: “El hecho de que el experimento fuera realizado con personas ya de por sí da evidencia concreta del funcionamiento del algoritmo”.

Una parte significativa de los desarrollos de la inteligencia artificial está dirigida a crear algoritmos que puedan detectar objetos y reconocerlos. Hay grandes avances en ese sentido. Pero, todavía, hay numerosas tareas en las que las personas somos mejores que las máquinas para ese cometido. “Eso es porque nuestro cerebro lo hace automáticamente y en un instante, sin necesitar del entrenamiento ni del ajuste que requieren los métodos computacionales de la inteligencia artificial”, ilustra Solovey, y añade: “Entender cómo los humanos hacemos una búsqueda puede ayudar a mejorar esos algoritmos”.

También, generar modelos computacionales que permitan hacer predicciones sobre nuestros comportamientos puede aportar a la comprensión de los procesos neuronales subyacentes: “Los movimientos oculares son una forma de medir varios procesos cognitivos, como la atención visual, el procesamiento de estímulos y la toma de decisiones”, ejemplifica Gastón Bujía.

Los resultados del trabajo se publicaron en la revista científica Frontiers in Systems Neuroscience. Lo firman Bujía, Solovey, Sebastián Vita y Juan Kamienkowski. También Melanie Sclar, durante cuya tesis de licenciatura se hizo el experimento con los voluntarios.

Voluntarios

Para sus experimentos, los investigadores requieren de la colaboración de personas que quieran ofrecer unas horas de su tiempo. Quienes deseen participar de los estudios como voluntarios pueden comunicarse a través del mail de Gastón Bujía (gastonbujia@gmail.com). En caso de que no puedan participar de manera presencial pueden también formar parte de otros experimentos en la página de neuropruebas.org.