IA para leer mejor

En tiempos en los que la inteligencia artificial genera tensiones y debates en el sistema educativo, un equipo argentino viene diseñando un sistema automático para evaluar el aprendizaje de la lectura. La herramienta responde a una necesidad de distintas provincias, permitiría monitorear de forma certera el nivel alcanzado e identificar tempranamente los casos con mayor dificultad.

Las evaluaciones sobre el desempeño de estudiantes de primaria y secundaria de las que más se habla son las que apuntan a la comprensión de texto y a las habilidades matemáticas. Suelen ser exámenes internacionales y estandarizados cuyos resultados muchas veces preocupan. Sin embargo, la base para llegar a comprender un texto es, lógicamente, la lectura.

“Se sabe que un chico que lee muy lento no va a poder comprender un texto, porque está haciendo un esfuerzo en leer y no en comprender”, afirma Pablo Riera, investigador en el Laboratorio de Inteligencia Artificial Aplicada (LIAA, UBA-CONICET). “Para que la comprensión pueda estar disponible, la lectura no tiene que ser un peso, eso es lo más importante porque fallar en la comprensión lectora es grave”, completa. Según el experto, los resultados recientes de las pruebas Aprender en estudiantes argentinos de tercer grado se ubican en torno a un cincuenta por ciento más bajo del nivel esperado.

En ese marco, las direcciones de educación de diferentes provincias del país vienen realizando monitoreos sobre la capacidad de lectura de sus estudiantes. Es ahí donde el equipo de Riera está encarando el desarrollo de un sistema automático que podría derivar en una aplicación al alcance del usuario. “Comenzamos hace poco más de dos años, con la participación de la Dirección General de Educación de la Provincia de Mendoza y financiamiento del Banco Mundial”, informa Riera. Y comenta: “hasta el momento no habíamos trabajado con aprendizaje de lectura y alfabetización en general”.

Los resultados recientes de las pruebas Aprender en estudiantes argentinos de tercer grado se ubican en torno a un cincuenta por ciento más bajo del nivel esperado.

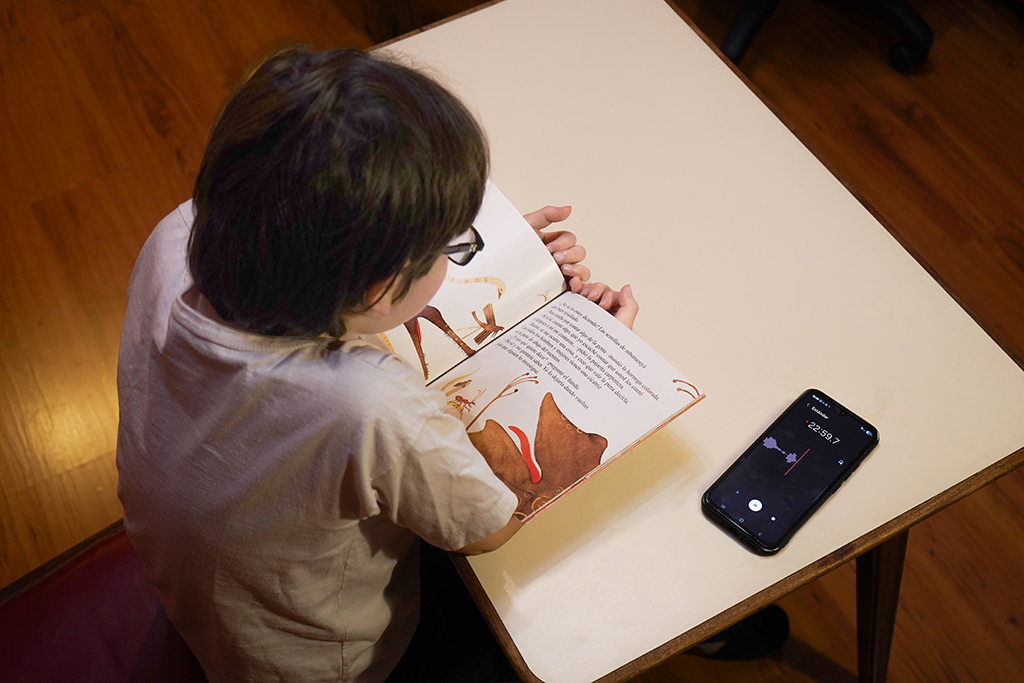

Mendoza realiza un censo en varios grados de primaria y hasta primer año del secundario. Su metodología es simple: graban a los chicos leyendo un texto y evalúan la fluidez motora. “Cuentan la cantidad de palabras del texto que llegan a leer de forma correcta en un minuto. Si leen muy lento o muy rápido pero atropellado, no está bien. Por supuesto, según la edad cambian los patrones de lectura”, aclara Riera. El investigador comenta que hay otra dimensión que todavía no están encarando, la prosódica, que implica respetar los signos de puntuación y la acentuación.

La grabación es cronometrada. Los estudiantes deben leer en un minuto el texto que se les brinda. El trabajo es escuchar los audios mientras se lee el texto original y marcar en cada palabra si la dijo bien. “Mendoza realiza un censo periódico a toda la población de estudiantes en toda la provincia. Es una escala grande. La duda que traían originalmente era si lo estaban haciendo bien, no tanto si se podía automatizar el proceso. Lo que vimos es que, efectivamente, lo que ellos reportaban y lo que nosotros analizamos era coherente”, detalla.

Lo artesanal

El proceso consiste en tomar el audio y pasarlo por un reconocedor del habla, que debe estar entrenado en español y adaptado al tipo de habla de los estudiantes. “La tarea es transcribir automáticamente las grabaciones de la forma más precisa posible para luego detectar las palabras correctas. Para eso usamos y ajustamos herramientas disponibles públicamente. Después, para evaluar la calidad de las transcripciones, hicimos un análisis muy detallado. Escuchamos cada audio y transcribimos exactamente lo que dijo cada chico, incluyendo los errores, por ejemplo, si pronunciaron mal una palabra o si titubearon. En español, esta tarea es relativamente sencilla, porque lo que se escucha suele corresponder bastante bien con lo que se escribe”, explica el investigador.

El proceso es tomar el audio y pasarlo por un reconocedor del habla, que tiene que ser en español y estar adecuado al tipo de habla de los estudiantes.

“Al hacer eso, tenemos la referencia casi perfecta de lo dicho y la podemos comparar con la transcripción automática para saber cuán bien hizo la tarea. Es arduo porque primero hay que transcribir, pero es lo más riguroso. Después aplicamos un método automático para realizar la comparación y sacar las métricas. Vimos que la tecnología podía hacer el trabajo y que nuestros resultados fueron compatibles con las estadísticas que ellos tenían. Por ejemplo, que la media en tercer grado para esta muestra fue leer ochenta palabras por minuto”, afirma.

Por ese motivo comenta que desde la gestión lo estaban haciendo bien, aunque desde el nivel estadístico, ya que a nivel individual “hay más dudas”: “El mayor problema es que si quien revisa la prueba es una persona, empieza a haber errores por ruido o cansancio, sobre todo si lo hace en cantidad”, agrega.

(De izq. a der.) Jazmín Vidal, Juan Kamienkowski, Octavio Castro y Pablo Riera. Foto: Diana Martinez Llaser

El científico relata que probaron dándoles las mismas grabaciones a cinco profesionales del área de capacitación docente en Mendoza. Si bien todos tenían las mismas instrucciones, en el momento fueron tomando distintas decisiones. “Algunos fueron más estrictos, otros menos, y aparecían diferencias muy importantes en las puntuaciones. También incidía el factor del ruido, algunos entendían menos y no incluían ciertas palabras”.

Según Riera, eso no es problemático al abordar categorías grandes, como la de los estudiantes que no leen prácticamente nada y con los que es necesario hacer un trabajo especial, pero sí lo es en cuanto a la cantidad de palabras. “Un evaluador humano tiene esos problemas –expresa– además, no puede escalar del todo, es muchísimo tiempo de trabajo. Entonces hay mucho interés en lograr esto de manera automática. Definitivamente ya tenemos una solución que sirve para el objetivo de hacer un censo, tenemos un error mínimo de cuatro palabras en promedio”, celebra.

Una máquina a toda letra

La posibilidad de monitorear cuantitativamente la fluidez y capacidad lectora del alumnado se inserta en tiempos de debates sobre la forma de enseñar a leer. ¿Se deben aplicar cambios en los métodos pedagógicos? ¿Hay que volver a lógicas más tradicionales? ¿Se piensa en implementar la inteligencia artificial en las aulas? Riera se ocupa de desarticular una idea equivocada sobre su trabajo: “no se trata de la IA enseñando lectura”, señala.

Para el experto, hoy resulta relativamente sencillo usar un chat bot y no habría un gran desafío tecnológico, sino un problema de política y diseño pedagógico. “Es una opinión personal, pero creo que, si se está pensando en sacar los teléfonos celulares del aula y en reducir las pantallas, sobre todo en edades tempranas, ¿con qué objetivo se introduciría un bot? Lo que sí tiene más sentido es darle estas herramientas al docente, porque podría producir ejercicios y generar materiales nuevos para sus clases”, propone. Y advierte: “El problema es si vamos a sustituir nuestras habilidades por la tecnología y delegar nuestro pensamiento. Si se hace eso, ¿para qué está uno en el medio?”.

La posibilidad de monitorear cuantitativamente la fluidez y capacidad lectora del alumnado se inserta en tiempos de debates sobre la forma de enseñar a leer.

Lo cierto es que la tecnología para realizar los monitoreos ya es un hecho. “Todavía no la estamos aplicando al censo”, comenta Riera. Y agrega: “Ahora estamos trabajando con otras provincias que evalúan de otra manera. Por ejemplo, hay casos en donde se mide la lectura con pseudo-palabras, que son sonidos que respetan las reglas de la lengua pero sin significado. Son estudiantes de segundo grado y se busca saber si pueden realmente decodificar el texto, porque es muy difícil a esa edad leer cosas que no conocés”, explica.

“Ahí les va peor que con las palabras conocidas. Y a nosotros también, porque la tecnología espera, de alguna manera, lo conocido. Entonces, tenemos que hacer pasos extra como indicar cuáles son las pseudo-palabras que se espera que lean para que el sistema automático las encuentre. Además, cuando los chicos están aprendiendo suelen leer las palabras de formas muy distintas, entonces la señal que analizamos es más compleja”, detalla Riera. Y suma: “Los reconocedores muchas veces completan con lo que era más probable. Y no está mal, porque si escuchan “tomat…” y transcriben “tomate”, quiere decir que entienden lo que se quiso decir, pero acá necesitamos penalizar eso”.

“Por eso ajustamos el sistema para que distinga entre lo que realmente se pronunció y lo que el modelo completa por probabilidad. Establecemos automáticamente un umbral de decisión a partir de la población analizada. En promedio el resultado es bueno, pero hay casos particulares con bastantes errores. Obviamente buscamos que no se nos escape ningún caso extremo”, completa.

A su vez, advierte sobre uno de los problemas que tiene el machine learning: “Se evalúa para un escenario, pero no funciona igual para todos”, dice. Y comenta que, al trabajar con varias provincias, podrían crear un sistema para cada una con distintos parámetros: “Por ejemplo, en una zona donde las ‘s’ se pronuncian muy suave podemos establecer ese criterio para no penalizar pronunciaciones típicas de un lugar que no tienen que ver con la decodificación de las letras”.

“Hay que seguir haciendo ajustes hasta que haya suficiente cantidad de datos. Ahora tenemos treinta mil grabaciones, pero si llegáramos a un millón, sería tan representativo que no variaría mucho sumándole otro millón”, agrega. Y plantea que pueden observar “algo con más interés académico”, como los tipos de errores: “Entender en qué se equivocan los chicos, no sólo monitorear la fluidez lectora. Así vamos definiendo cuáles son los principales problemas para cada nivel”.

A futuro proyectan generar una plataforma con este sistema. “Incluso podría usarlo cualquiera en su casa, funcionaría como una autoevaluación. Lo ideal sería que fuera una APP para el teléfono”, se entusiasma Riera. “Ahora devuelve un puntaje y puede indicar el rango de la población y tu ubicación dentro del mismo, también puede realizar un desglose de los principales problemas para mejorar. La tecnología anda bien, alcanza para medir si un niño lee muy poco. Eso es importante, porque si llega a determinada edad sin leer es un problema y es mejor tomarlo a tiempo”, resume.

El equipo

Al grupo que trabaja con Pablo Riera en el LIAA lo integran Jazmín Vidal, licenciada en Letras y doctoranda en Ciencias de la Computación especializada en reconocedores del habla aplicados a la enseñanza de la lengua; Juan Kamienkowski, investigador especialista en neurociencias; Octavio Castro, doctorando en Ciencias de la Computación, y Luciana Ferrer, investigadora del laboratorio como consultora.