Se hace camino al andar

Un equipo de investigación desarrolló un innovador sistema de localización y mapeo en 3D “denso”, que permite hacer una reconstrucción tridimensional del entorno mucho más precisa y en tiempo real, montado sobre pequeños robots móviles terrestres o aéreos para tareas de búsqueda y rescate y para otras aplicaciones en la industria, el agro o la conservación del ambiente.

Un equipo del Departamento de Computación de la Facultad de Ciencias Exactas y Naturales de la UBA desarrolló el primer sistema de localización y mapeo en 3D “denso”, que puede funcionar a bordo de pequeños robots móviles terrestres o en drones y permite realizar una reconstrucción tridimensional del ambiente consistente y en tiempo real.

El trabajo, que tiene como autores a Emiliano Höss y Pablo De Cristóforis, fue presentado en mayo pasado en la International Conference on Robotics and Automation (ICRA), el encuentro más importante del mundo para esta disciplina, que tuvo lugar en Atlanta, Estados Unidos, y ofrece una innovadora respuesta a un dilema clásico de la robótica: cómo puede un robot desplazarse por un entorno desconocido, lleno de obstáculos, sin tener un mapa previo, y cómo puede crear un mapa desde cero a medida que recorre ese entorno.

“Imaginemos un robot que tiene que ir a rescatar personas que quedaron atrapadas en una mina o en un edificio que se derrumbó –comienza Pablo De Cristóforis, doctor en Ciencias de la Computación, investigador del Instituto de Ciencias de la Computación (ICC, UBA – CONICET) y director del Laboratorio de Robótica y Sistemas Embebidos–. Debe encontrar a esas personas lo más rápidamente posible, de forma autónoma, sin conocer previamente su ubicación ni el recorrido o el mapa necesario para llegar hasta ellas”.

¿Cómo puede un robot desplazarse por un entorno desconocido, lleno de obstáculos, sin tener un mapa previo, y cómo puede crear un mapa desde cero a medida que recorre ese entorno?

El desarrollo, bautizado coVoxSLAM, consiste en un novedoso sistema SLAM (Simultaneus Localization and Mapping) acelerado con placas GPU (unidad de procesamiento de gráficos) que aprovecha al máximo la potencia de procesamiento paralelo para construir mapas globalmente consistentes, incluso en entornos a gran escala.

“El SLAM es un problema muy estudiado en robótica móvil. Concretamente –explica De Cristóforis– consiste en poder mapear o generar una representación, un modelo de un espacio dado al mismo tiempo que el robot se localiza en ese mapa. Esto es fundamental para resolver la navegación autónoma de cualquier agente, robot o máquina móvil, por ejemplo, un vehículo autónomo que necesite operar en un entorno desconocido y que; por lo tanto, no tiene una representación previa, y no puede basarse solamente en la señal de GPS, o bien porque trabaja en un ambiente interior, donde no hay señal clara, o bien porque está en un bosque o en algún lugar sin cobertura, por ejemplo una mina o hasta en otro planeta, donde no hay GPS”.

El investigador describe un dispositivo que podría tener los más diversos usos: para la agricultura de precisión, en tractores autónomos; para la industria y la logística, con robots que llevan piezas de producción de una estación de trabajo a otra o muevan mercadería en almacenes inteligentes; para misiones exploratorias en Marte o en la Luna, entre otros.

Hasta no hace mucho, este proceso clave para la navegación autónoma se realizaba montando sobre el robot un hardware tradicional, una CPU con cámaras o dispositivos láser que construía una representación del entorno basada en puntos, a partir de la cual se puede generar una suerte de “malla” del espacio explorado. En cualquier caso, se trata de una representación incompleta del ambiente, ineficaz para planificar trayectorias seguras, evadir obstáculos o manipular objetos.

El desafío es procesar toda esa información en milisegundos para que el robot pueda navegar, interactuar y tomar decisiones en tiempo real.

“Reconstruir ese entorno con el mayor detalle posible, es esencial para poder tomar decisiones en tiempo real, planificar rutas seguras, evitar los obstáculos e interactuar con objetos, personas u otros robots. Y ahí es donde entran en escena las GPU”.

Con la irrupción de las placas de procesamiento de gráficos, el poder de cómputo disponible aumentó exponencialmente, con muchos núcleos computacionales más pequeños y especializados que trabajan en paralelo y permiten procesar imágenes con mayor velocidad, manipular datos de video en tiempo real y ejecutar algoritmos de IA y aprendizaje automático de manera intensiva.

“Nosotros ya habíamos hecho trabajos previos de SLAM, pero nos propusimos que esos algoritmos pudieran correr a bordo de los propios robots. Y las GPU, cada vez más potentes, que antes se usaban para videojuegos, después para minar criptomonedas y hoy para inteligencia artificial, no solo se pueden poner en un servidor o en una computadora personal. También pueden integrarse en sistemas inteligentes embebidos a bordo de pequeños robots móviles”.

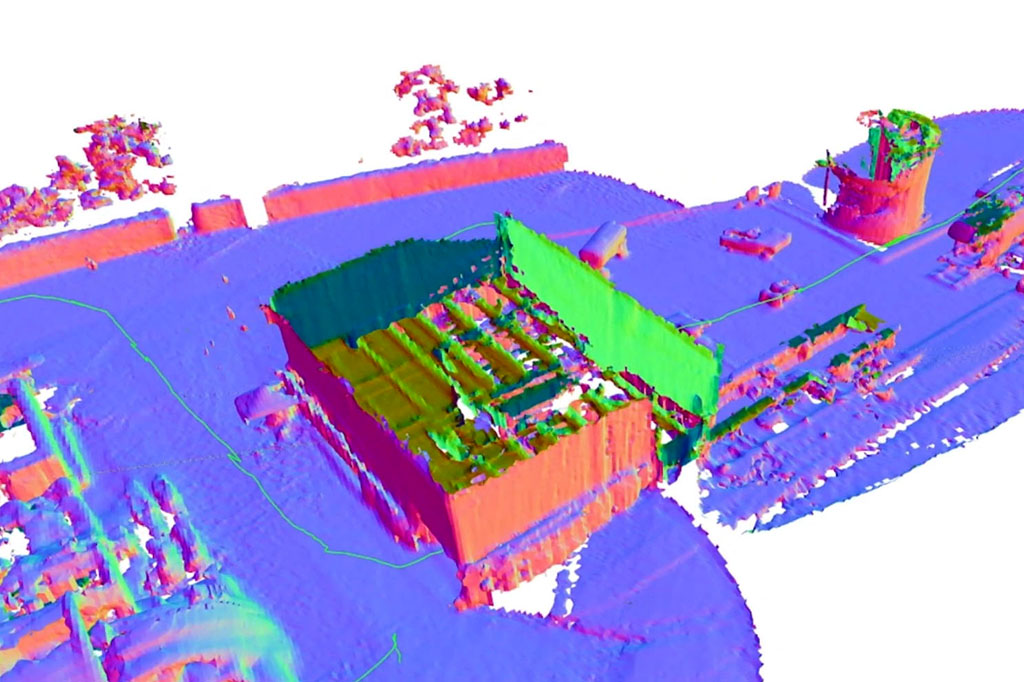

Esto supone, además, una exponencial mejora en el procesamiento de las imágenes que son capturadas por las cámaras que van montadas en los robots. El mapeo denso logra entonces representaciones volumétricas del ambiente, mediante vóxeles –equivalentes a los píxeles pero en un espacio tridimensional-. A diferencia de la representación dispersa basada en nubes de puntos que estiman las distancias a partir de triangulaciones, “la representación densa informa las dimensiones y la geometría exactas de ese entorno, un modelo más rico que permite planificar trayectorias e interactuar con objetos de manera mucho más segura y realista en el ambiente”, puntualiza De Cristóforis.

El SLAM 3D denso resulta óptimo para tareas de búsqueda y rescate, o de alerta temprana en entornos peligrosos o cualquier lugar hostil a la presencia humana.

En rigor, el SLAM denso desarrollado por Höss y De Cristóforis superó al de la Universidad Politécnica ETH Zurich, pionera en el área, a partir de un modelo hasta un ciento por ciento más eficiente en términos de tiempos de ejecución. La clave de coVoxSLAM –que pone de manifiesto el enorme potencial de generación de conocimiento que hay en la Argentina en las áreas de robótica, automatización e inteligencia artificial– es que incorpora GPU tanto en el frontend como en el backend del sistema (donde los suizos continuaban corriendo su programa en CPU).

“El desafío es procesar toda esa información en milisegundos para que el robot pueda navegar, interactuar y tomar decisiones en tiempo real. Hasta aquí, no había un SLAM completo implementado íntegramente en GPU. El frontend es la parte del sistema que percibe, captura y procesa la información de los sensores, y el backend, la parte que ajusta todos esos datos y va construyendo el mapa de manera consistente. Lo que generamos, con GPU también en el backend, se basa en un método de optimización no lineal que permite ejecutar todo el programa en tiempo real y hacerlo globalmente consistente. Esto significa que, a medida que el robot va moviéndose y generando el mapa, si vuelve a visitar una zona, pueda darse cuenta de que está en un lugar ya previamente recorrido, lo que se conoce como ‘cierre de ciclos’, y aprovechar esta información para ajustar tanto la estimación de su ubicación como el mapa construido hasta el momento. En ese sentido es el primer sistema ‘denso’”, explica De Cristóforis, quien presentó el trabajo en Atlanta y, en un reconocimiento a la relevancia del aporte científico del proyecto, fue seleccionado como co-chair de la sesión de SLAM de la ICRA.

Las aplicaciones, como ya se dijo, son múltiples, en robots terrestres, aéreos y aun acuáticos. En concreto, el grupo de estudio que lidera De Cristóforis en la Facultad de Ciencias Exactas y Naturales de la UBA, viene desarrollando un proyecto para aplicar el dispositivo al monitoreo de bosques nativos utilizando drones. “Estamos trabajando con un pequeño vehículo aéreo no tripulado de ala fija, ya no un multicóptero, con más envergadura y varios sensores a bordo, entre ellos una cámara de gran resolución que permite hacer fotogrametría, para poder contar con una reconstrucción tridimensional del bosque e incluso saber qué especie de árbol hay en cada posición espacial y geolocalizarlo, en función de la conservación de especies nativas, del monitoreo de la competencia con especies invasoras para hacer tala selectiva, o para evaluar la presencia de biomasa combustible y desplegar estrategias de alerta temprana en manejo del fuego. Para todas estas situaciones, se utilizan algoritmos de reconstrucción 3D”.

Por supuesto, el SLAM 3D denso resulta óptimo para tareas de búsqueda y rescate, o de vigilancia y alerta temprana en entornos peligrosos, en minas, instalaciones petroleras o cualquier lugar hostil a la presencia humana. Pero también podría ser utilizado en aplicaciones de realidad aumentada para celulares en lugares donde la señal de GPS tiene alcance limitado, como ocurre dentro de edificios, para saber cómo llegar a una oficina, o en locales comerciales, para encontrar, por ejemplo, determinado producto en una góndola de supermercado.

El artículo que acompañó la presentación de coVoxSLAM y que generó un gran interés en la conferencia de robótica se basó en la tesis de licenciatura en Ciencias de la Computación de Höss. Lo que sigue es enviarlo, en una versión más extensa y con nuevos aportes, para su publicación en IEEE Transactions on Robotics, la revista más prestigiosa de la disciplina.

Y reunir nuevos fondos para poder simular todos estos algoritmos en el hardware, acumular capacidad de cómputo para entrenarlos y, como es lógico en el horizonte de investigadores de sistemas embebidos, testearlos en robots reales. En efecto, en los estantes del “labo” y en un depósito del Cero+Infinito se amontonan los drones experimentales, robots terrestres y un pequeño robot hexápodo, de seis patas articuladas, muchos de ellos diseñados por el propio grupo, que pronto contarán con una extraordinaria herramienta para saber exactamente por dónde van.